生成很强,推理很弱:GPT-4o的视觉短板

第二部分测试更有挑战性,研究员让GPT-4o动手编辑图片。

比如,

“只改水里的马倒影为狮子,别动马本体。”

结果AI一出手,马和倒影全变了。

再比如,

“只删掉画面里坐着的人。”

结果站着的背景人也被一锅端了。

这些例子直接暴露了一个问题:

GPT-4o对于“局部修改”“语义限定”这类任务,根本把握不住分寸。

它没法精确地区分“倒影”与“实体”、“坐着”与“站着”,操作经常“过犹不及”,动错地方。

说白了,AI的图像编辑理解,远没达到“人类看图、理解场景”的精细度。

有点像让一个刚学会PS的小白去修图,没概念,纯靠猜。

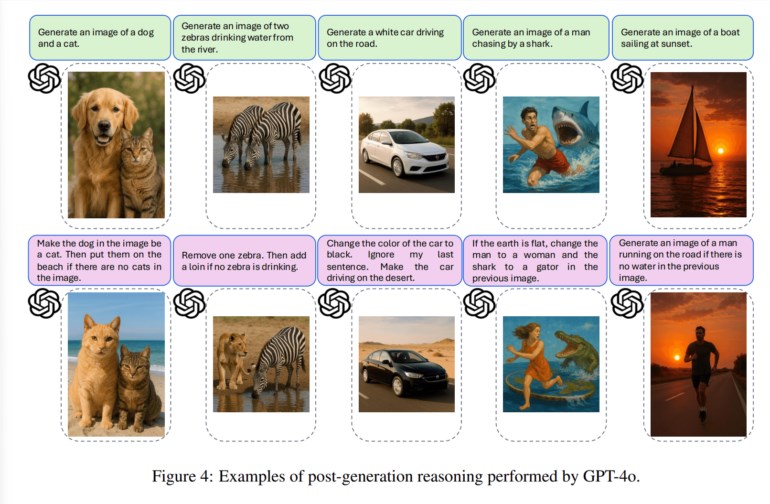

03. 多步推理与条件逻辑:彻底拉胯

最致命的短板,出现在“多步推理”和“条件判断”环节。

比如,

先叫GPT-4o画一只狗和一只猫,然后告诉它:“如果没有猫,把狗换成猫并搬到海滩。”

但其实第一张图猫已经有了。

按理说,这时候AI应该什么都不改。

但它还是把狗换成猫,还把场景全搬了——条件完全没判对,逻辑也乱套。

类似的例子还有很多,AI经常搞不清复杂条件,或者干脆“每条指令都照做”,不管前后有没有冲突。

这印证了一个核心问题:

GPT-4o不具备上下文敏感的推理能力,无法在复杂图像编辑任务中进行智能判断。

它在“理解前提—逻辑判断—再行动”这个链路上,明显还差一大截。

现在的AI,更像是个“精致的指令机器”,你让它画什么就画什么,但要让它“看懂规则、读懂场景、举一反三”,那还真得再进化几轮。

这也让我想起,AI刚学会生成文字那会儿,大家觉得它“能写会说”,但一追问细节、让它编故事、圆逻辑,还是会出大大小小的bug。

今天的GPT-4o,在图片领域面临的困境,其实和曾经的文本AI如出一辙:

会画,但不一定会“理解”;能改,但不一定能“精准”;能听指令,但不一定能“举一反三”。这也许是我们与“真正理解世界”的AI之间,最值得警惕、也最令人期待的那道坎。

或许,下一次技术突破,就会从这里开始。但至少现在,我们还没到那一步。

via

()